Darkrealms是一个历史悠久的MS-DOS公告板系统(BBS),自1994年以来一直在线,是Fidonet 1区枢纽。它拥有大量的Echomail档案和稀有的老式计算机文件。用户可以通过Telnet(bbs.darkrealms.ca)使用SyncTerm等客户端连接,甚至可以使用拨号调制解调器(+1-647-847-2083)。

截至2026年3月10日,Darkrealms显示出显著的活动,已建立超过306,000个连接,并进行了大量数据传输(发送超过18MB,接收337KB)。该系统处理大量的邮件和Echomail,将消息转发到许多地区。

该网站提供有关连接、邮件流量和文件可用性的详细统计信息,展示了它作为Fidonet网络中重要节点的重要作用。它维护着明确的节点列表政策,要求遵守Policy 4并证明Netmail交换能力。

每日HackerNews RSS

## ma:一个精简的 Acme 克隆 “ma”是一个轻量级的、基于Tcl/Tk的编辑器,灵感来自Plan 9的acme编辑器。它优先考虑鼠标驱动的交互,旨在实现一种轻松的、单手操作的工作流程,而不是像Emacs这样的编辑器那样以键盘为中心。虽然更简单,“ma”允许通过基于文本的命令和鼠标操作进行动态UI扩展。 主要特性包括一个单窗口界面(窗口管理交给系统处理)、通过`~/.ma`文件进行配置,以及一个用于定位打开文件的“注册表”。它支持基本编辑功能、通过正则表达式进行文件处理,以及用于自定义的环境变量。 目前,“ma”在Linux、OpenBSD和Mac OS X(使用XQuartz)上经过测试,但Mac/Aqua和Windows支持有限。该项目仍在进行中,存在一些已知错误和缺失的功能,包括一个强大的“Kill”命令、备份功能以及完全的acme兼容性。用户可以通过将脚本添加到PATH中或在Tcl环境中定义命令来扩展“ma”。

伊朗最近对阿联酋和巴林的三处亚马逊网络服务(AWS)数据中心进行的无人机/导弹袭击,标志着首次针对这些关键基础设施枢纽的蓄意空中袭击。袭击导致服务中断,影响了从银行到送货应用程序的服务,并可能影响美国军方利用AWS执行人工智能驱动的情报等功能。 此事件凸显了商业云计算与军事行动界限日益模糊,因为五角大楼越来越依赖与民用企业相同的 инфраструктура. 数据中心现在是至关重要的战略资产,并且越来越容易受到网络和物理攻击——特别是随着人工智能的重要性日益提高。 目前的数据中心安全主要侧重于地面威胁,使其容易受到空中破坏冷却系统和电源供应的影响。专家警告说,此类袭击可能会变得更加频繁,并可能扩展到中东以外地区,甚至以关键海底数据电缆为目标。该事件给海湾地区成为全球人工智能中心的愿景蒙上了一层阴影,引发了对这些投资安全性的担忧。

最近公开的“JVG算法”声称在分解大数方面优于Shor算法,可能仅用5000个量子比特就能破解RSA-2048加密。然而,这一说法从根本上是错误的。 JVG算法试图通过经典预计算结果,然后将其加载到量子态中来加速Shor算法中的关键步骤。作者指出这是不可能的;计算和加载指数数量的值需要指数级的*时间*,实际上是将一个棘手的问题换成了另一个棘手的问题。 该论文发表在一个不太可靠的预印本服务器(“Preprints.org”而非arXiv)上,并通过耸人听闻的新闻网站获得了关注,而主流科学媒体却对此置若罔闻。作者批评这项工作表明对基本原理的漠视,并将其作为对未经证实的主张的警示,尤其是在数学和量子计算领域。

## Emacs Solo:无包两年 Emacs Solo 是一个个人 Emacs 配置,基于一个严格的原则:不使用外部包。经过两年,作者反思了这个项目的演变,其动力来自于理解 Emacs 的核心能力、维护不同版本之间的稳定性,以及避免包管理带来的麻烦。 最新的重大变化是重构了架构,将配置分为两层:`init.el` 用于核心 Emacs 定制(仅使用内置包),以及 `lisp/` 目录用于 35 个独立的 Elisp 模块,复制了通常在外部包中找到的功能。这种分离提高了可维护性和清晰度。 `init.el` 文件配置了基本功能,如键绑定、窗口管理、文件处理和核心模式(Org、VC、Eshell 等),利用了 Emacs 31 的改进。`lisp/` 模块提供了流行的包的替代品——主题、彩虹分隔符、剪贴板集成等等——从头开始构建,以实现完全控制。 作者强调 Emacs 默认情况下提供了令人惊讶的强大功能,并且构建自定义解决方案是一种宝贵的学习体验。该项目可在 [GitHub](https://github.com/LionyxML/emacs-solo) 上找到,并感谢 Emacs 核心团队和更广泛的 Emacs 社区的贡献。

打开一个真实的 Boss TU3 开始调音

总调音次数:0

常见问题解答▶为什么?

真正的吉他手使用真实的调音器。

▶这个调音器物理上位于哪里?

在这个盒子里。

▶我可以在任何时候使用它吗?

是的。

▶它是如何工作的?

由 Kyle 制作

打开一个真实的 Boss TU3 开始调音

总调音次数:0

常见问题解答▶为什么?

真正的吉他手使用真实的调音器。

▶这个调音器物理上位于哪里?

在这个盒子里。

▶我可以在任何时候使用它吗?

是的。

▶它是如何工作的?

由 Kyle 制作

alphaXiv探索 登录 实验室 反馈 浏览器扩展 深色模式 我们正在招聘 论文 博客 资源 76/ - 隐藏工具 Ctrl + / Helios: 实时长视频生成模型 助手 我的笔记 评论 相似

乔纳森·鲍温告诉我托尼·霍尔于3月5日星期四去世。https://en.wikipedia.org/wiki/Tony_Hoare 托尼·霍尔通过他的著作是我的导师之一,包括:Dahl, O.-J.; Dijkstra, E. W.; Hoare, C. A. R. (1972). Structured Programming. Academic Press. ISBN 978-0-12-200550-3. OCLC 23937947. C. A. R. Hoare (1985). Communicating Sequential Processes. Prentice Hall International Series in Computer Science. ISBN 978-0131532717 (精装本) 或 ISBN 978-0131532892 (平装本)。(可在 http://www.usingcsp.com/ 存档于 Wayback Machine 的 PDF 格式在线获取。) 我将您转到 https://www.researchgate.net/profile/Jonathan-Bowen-2/publication/251422442_Oral_History_of_Sir_Antony_Hoare/links/6071ada14585150fe999e6de/Oral-History-of-Sir-Antony-Hoare.pdf 和 FACTS T Denvir, J He, CB Jones, AW Roscoe, J Stoy, B Sufrin, JP BowenFACS FACTS 2024 (2), 5-42

## 跨平台开发:一次讽刺性的回顾

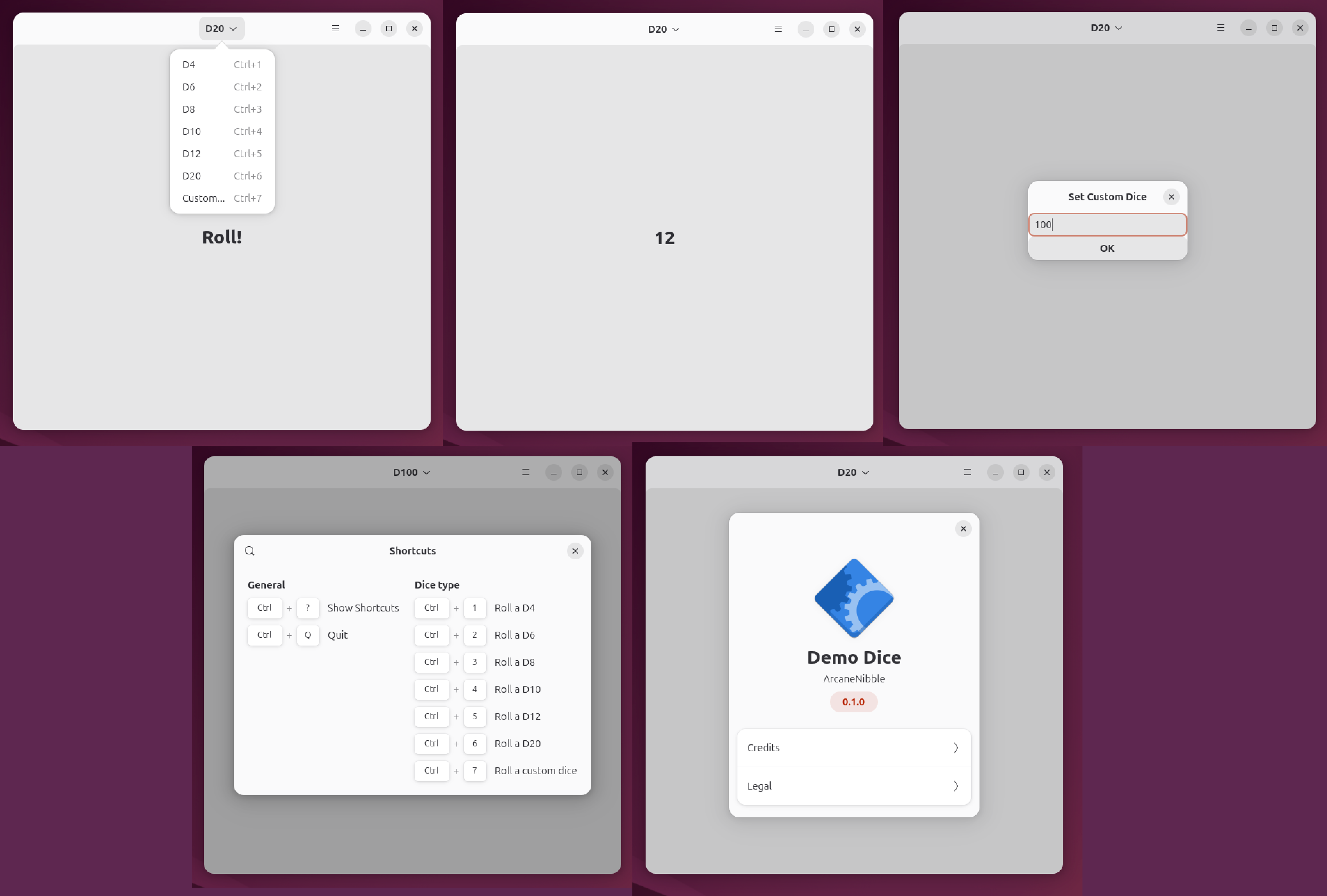

出于对现代开发者体验(超越Web技术)的好奇,作者将一个简单的骰子程序移植到各种平台:标准C、C/POSIX、Linux (GTK & KDE)、Windows (WinUI 3)、macOS/iOS (SwiftUI) 和 Android (Jetpack Compose)。目标是评估工具和基本UI构建,并添加持久设置和本地化以增加复杂性。

这次旅程揭示了一个碎片化的景象。标准C证明了其惊人的韧性,而POSIX则显得过时。GTK/GNOME展现出潜力,但受限于不完整的文档和令人沮丧的调试。KDE/Qt提供了一种更务实的用户体验,尽管CMake是一个显著的障碍。WinUI 3功能可用,但感觉一如既往地像微软的产品——复杂且缺乏灵感。SwiftUI使用起来很愉快,但深深地嵌入在苹果的封闭花园中。Android上的Jetpack Compose令人最失望,文档碎片化且感觉粗糙。

每个平台都得到了一句讽刺性的总结:C – 最抗过时;POSIX – 最无用;GTK – 最浪费潜力;Qt – 最受平台限制;WinUI 3 – 最缺乏灵感;SwiftUI – 最有趣的消遣;Jetpack Compose – 最“原形毕露”。

最终,这次实验突出了跨平台开发的挑战、清晰文档的重要性,以及不同生态系统中对开发者的不同程度的重视。Qt 似乎是一个可行的选择,但总体而言,这次体验强调了改进标准化和更尊重开发者时间的必要性。

## 跨平台开发:一次讽刺性的回顾

出于对现代开发者体验(超越Web技术)的好奇,作者将一个简单的骰子程序移植到各种平台:标准C、C/POSIX、Linux (GTK & KDE)、Windows (WinUI 3)、macOS/iOS (SwiftUI) 和 Android (Jetpack Compose)。目标是评估工具和基本UI构建,并添加持久设置和本地化以增加复杂性。

这次旅程揭示了一个碎片化的景象。标准C证明了其惊人的韧性,而POSIX则显得过时。GTK/GNOME展现出潜力,但受限于不完整的文档和令人沮丧的调试。KDE/Qt提供了一种更务实的用户体验,尽管CMake是一个显著的障碍。WinUI 3功能可用,但感觉一如既往地像微软的产品——复杂且缺乏灵感。SwiftUI使用起来很愉快,但深深地嵌入在苹果的封闭花园中。Android上的Jetpack Compose令人最失望,文档碎片化且感觉粗糙。

每个平台都得到了一句讽刺性的总结:C – 最抗过时;POSIX – 最无用;GTK – 最浪费潜力;Qt – 最受平台限制;WinUI 3 – 最缺乏灵感;SwiftUI – 最有趣的消遣;Jetpack Compose – 最“原形毕露”。

最终,这次实验突出了跨平台开发的挑战、清晰文档的重要性,以及不同生态系统中对开发者的不同程度的重视。Qt 似乎是一个可行的选择,但总体而言,这次体验强调了改进标准化和更尊重开发者时间的必要性。