## NemoClaw:英伟达的企业级AI代理平台 NemoClaw是英伟达即将推出的开源平台,旨在为企业带来安全且可扩展的AI代理。作为对OpenClaw快速增长——以及随后被OpenAI收购——的回应,NemoClaw为需要自主任务自动化的企业提供了一种可靠且可定制的替代方案。 与面向消费者的代理不同,NemoClaw优先考虑企业级安全性和隐私,内置了安全保障和数据治理工具。它与英伟达的NeMo框架和NIM微服务深度集成,以实现优化性能,但值得注意的是,它**硬件无关**,可在英伟达、AMD、Intel和其他处理器上运行。 主要功能包括通过开源访问进行深度定制、跨部门的任务自动化,以及与Salesforce、Cisco和Google等不断增长的合作伙伴生态系统集成。英伟达设想NemoClaw将作为“企业代理时代”的基础层,将其影响力从硬件扩展到AI软件领域。 NemoClaw计划在GTC 2026上正式发布,标志着向企业级生产AI代理的关键转变。

每日HackerNews RSS

请启用 JavaScript 并禁用任何广告拦截器。

## 工程赋能 - AI 与生产力更新 本周的工程赋能简报关注 AI 对开发者生产力的*实际*影响。尽管有炒作称收益可达 2-3 倍,但一项 DX 研究分析了 40 家公司一年的数据,显示**拉取请求处理量**的增幅较为适中,为 **9.97%**,同时 **AI 使用率上升了 65%**。 这与工程领导的反馈一致,他们报告的收益通常在 8-12% 之间。关键要点是:**编码并非主要的瓶颈**。开发者表示 AI 使任务*略微*更容易,但仍需花费大量时间进行规划、对齐、审查和其他非编码活动。 该研究将继续调查为什么有些团队比其他团队受益更多,旨在为领导者提供见解,以最大限度地发挥 AI 的潜力。3 月 19 日将举行与 Abi 的现场问答环节,进一步讨论这些话题。

斯特凡·法特西斯的《未删减版》探讨了现代词典,特别是韦氏词典,令人惊讶的动态历史。法特西斯挑战了人们对词典是静态权威的认知,揭示了编辑们如何越来越多地根据人们实际使用语言的方式来制定定义,追踪从拼字游戏搜索到9/11事件和COVID-19疫情后查询激增等趋势。

本书详细描述了从规范性词典(旨在规定“正确”用法)到描述性词典的转变,反映了语言的演变。这种变化并非没有争议,1961年第三版因收录“ain’t”等词汇而引发的强烈反对就是一个例子。

法特西斯本人在韦氏词典内部的经历,试图用他偏好的术语来影响词条,突显了传统与当代用法之间持续存在的紧张关系。虽然质疑词典在数字时代的未来,但他最终证明了人类编辑在定义语言方面仍然具有持久的价值,这是人工智能目前无法复制的过程。尽管面临挑战,韦氏词典仍然是一个强大的机构,不断适应并记录英语语言不断变化的图景。

斯特凡·法特西斯的《未删减版》探讨了现代词典,特别是韦氏词典,令人惊讶的动态历史。法特西斯挑战了人们对词典是静态权威的认知,揭示了编辑们如何越来越多地根据人们实际使用语言的方式来制定定义,追踪从拼字游戏搜索到9/11事件和COVID-19疫情后查询激增等趋势。

本书详细描述了从规范性词典(旨在规定“正确”用法)到描述性词典的转变,反映了语言的演变。这种变化并非没有争议,1961年第三版因收录“ain’t”等词汇而引发的强烈反对就是一个例子。

法特西斯本人在韦氏词典内部的经历,试图用他偏好的术语来影响词条,突显了传统与当代用法之间持续存在的紧张关系。虽然质疑词典在数字时代的未来,但他最终证明了人类编辑在定义语言方面仍然具有持久的价值,这是人工智能目前无法复制的过程。尽管面临挑战,韦氏词典仍然是一个强大的机构,不断适应并记录英语语言不断变化的图景。

经过数十年的过程,英国上议院即将取消其剩余的世袭贵族,结束几个世纪以来贵族在议会中的特权。最近的投票最终通过了立法,取消了最后25位继承席位的公爵、伯爵和子爵,政府称此举结束了“过时且不民主的原则”。 尽管上议院在审查立法方面仍然发挥着关键作用,但批评者长期以来认为其庞大的规模(仅次于中国立法机构)和未选举产生的性质存在问题。这一变化是在1999年改革的基础上进行的,当时已经取消了大多数世袭贵族,只剩下92人。一项妥协方案允许一些人通过过渡到“终身贵族”身份而继续留任。 工党政府的目标是最终用一个更具代表性的第二议院取代上议院,但重大的改革预计将是一个缓慢的过程。此举标志着一个时代的结束,承认了世袭贵族的历史贡献,同时也拥抱了一个更注重能力原则的体系。

## AI 代码生成与实际用处:脱节

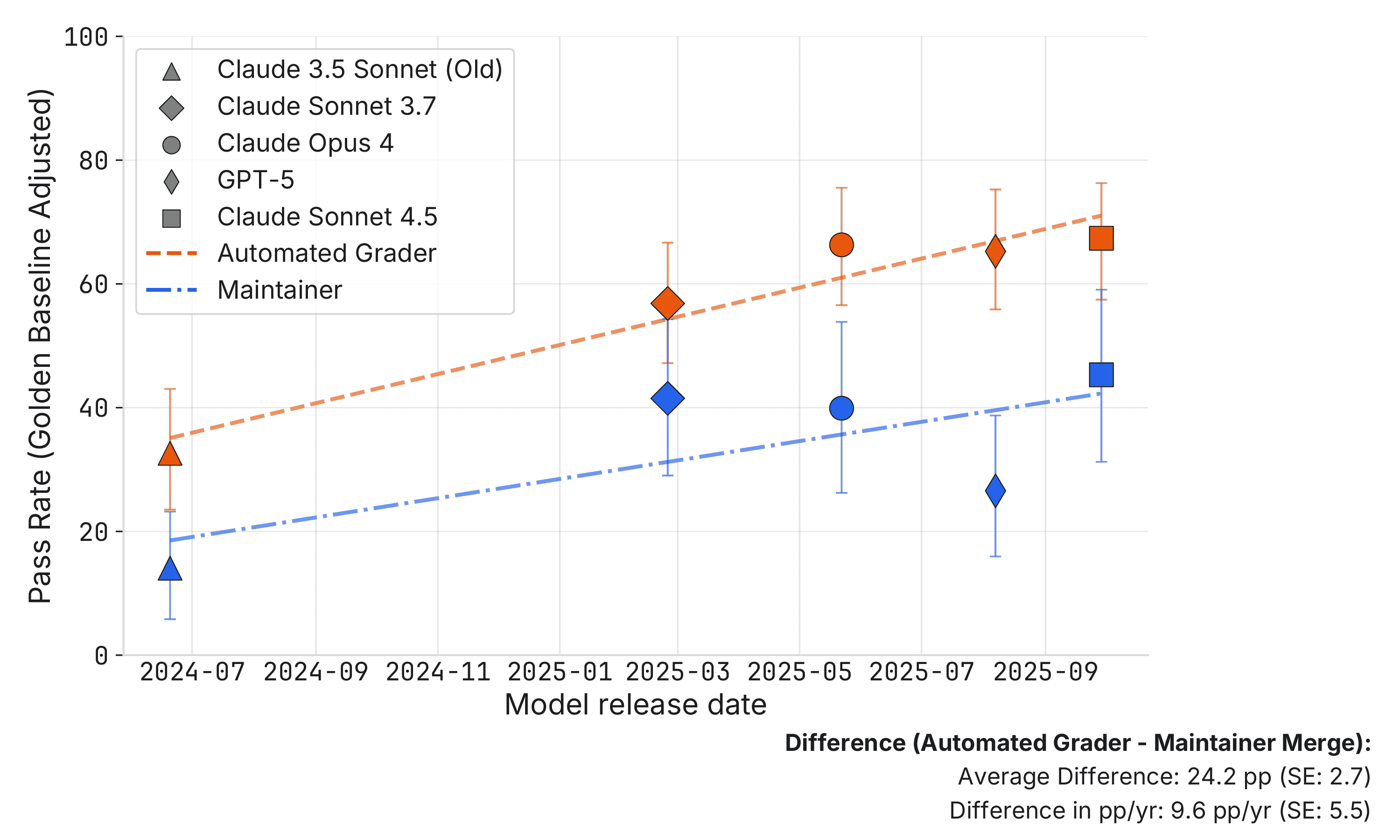

一项最新研究调查了 AI 生成代码的实际应用性,评估依据是 SWE-bench Verified 基准测试。研究人员请三个开源项目的活跃维护者审查 296 个 AI 生成的拉取请求 (PR),这些 PR 都*通过*了自动化的 SWE-bench 评分器。结果显示存在显著差距:大约一半的通过测试的 PR 将不会被人工维护者合并。

这种差异不一定代表 AI 能力的局限性,而是凸显了自动化测试与人工代码审查之间的区别。维护者要求修改是由于代码质量、对仓库标准的遵守或核心功能问题。将分数与人工编写的“黄金补丁”进行标准化对比显示,维护者合并率比 SWE-bench 分数低约 24 个百分点,且改进速度较慢。

该研究强调,基准测试分数可能会高估代理的实用性,如果未纳入人工反馈和迭代改进——这是人工开发者标准的流程。虽然基准测试对于比较模型很有价值,但将其直接转化为实际影响具有挑战性,需要谨慎。研究结果表明,需要更细致的评估方法来考虑人工工作流程的复杂性。

## AI 代码生成与实际用处:脱节

一项最新研究调查了 AI 生成代码的实际应用性,评估依据是 SWE-bench Verified 基准测试。研究人员请三个开源项目的活跃维护者审查 296 个 AI 生成的拉取请求 (PR),这些 PR 都*通过*了自动化的 SWE-bench 评分器。结果显示存在显著差距:大约一半的通过测试的 PR 将不会被人工维护者合并。

这种差异不一定代表 AI 能力的局限性,而是凸显了自动化测试与人工代码审查之间的区别。维护者要求修改是由于代码质量、对仓库标准的遵守或核心功能问题。将分数与人工编写的“黄金补丁”进行标准化对比显示,维护者合并率比 SWE-bench 分数低约 24 个百分点,且改进速度较慢。

该研究强调,基准测试分数可能会高估代理的实用性,如果未纳入人工反馈和迭代改进——这是人工开发者标准的流程。虽然基准测试对于比较模型很有价值,但将其直接转化为实际影响具有挑战性,需要谨慎。研究结果表明,需要更细致的评估方法来考虑人工工作流程的复杂性。

人工智能正越来越多地被用于进行初步的职位面试,像CodeSignal和Humanly这样的公司正在使用人工智能化身通过视频通话来评估候选人。支持者认为这扩大了面试机会并减少了偏见,使更多的申请者能够被考虑。然而,由于真正无偏见的人工智能仍然难以实现——这些系统是基于反映现有社会偏见的数据进行训练的,因此担忧正在增加。 最近的一项实验表明,虽然一些人工智能面试平台感觉比其他平台更自然,但体验始终缺乏人类互动的细微差别和联系。作者亲自测试了三个平台,用于各种职位,并在整个过程中都希望与真人交流。这引发了关于招聘未来的问题,以及人工智能是否真的能够有效地和公平地评估候选人。

伊朗、以色列和美国之间的紧张局势现已扩展到网络和基础设施战。在近期袭击波斯湾AWS数据中心的无人机袭击事件后,伊朗国家媒体明确点名谷歌、微软、帕兰蒂尔、英伟达和甲骨文等美国大型科技公司,称它们可能成为目标,理由是它们与以色列的联系以及军事应用。 这一警告由与伊斯兰革命卫队有关的媒体发布,标志着冲突范围的扩大,从传统的军事目标扩展到经济基础设施。伊朗以以色列袭击其自身经济目标(如Sepah银行)为由,为这种扩展辩护。 这一威胁凸显了该地区关键技术基础设施的脆弱性,特别是云服务和数据中心,并引发了对现代经济潜在中断的担忧。到目前为止,上述美国公司尚未公开对事态发展发表评论。

启用 JavaScript 和 Cookie 以继续。

## Anthropic、美国国防部和人工智能控制的未来 美国国防部试图迫使Anthropic移除其人工智能模型中防止用于大规模监控和自主武器的保障措施,凸显了一个关键的未来挑战:谁来控制日益强大的人工智能?Anthropic的拒绝引发了对其公司进行有效解体的威胁,引发了人们对政府过度干预以及人工智能可能被武器化以对抗民主原则的担忧。 作者认为,虽然政府对人工智能有合法的需求,但赋予一家私营公司对关键技术的“关闭开关”是不可接受的。然而,仅仅拒绝合作不是问题所在——仅仅因为坚持其价值观而威胁摧毁一家公司,会造成一个危险的先例。随着人工智能融入所有领域,包括国防,政府可能会试图胁迫*所有*人工智能提供商,从而可能扼杀创新,并将发展导向监管较少的实体。 核心问题在于,人工智能本质上有利于专制控制,能够实现前所未有的监控能力。虽然监管是不可避免的,但作者担心监管框架可能会被滥用以压制异议和控制人口。解决方案不仅仅是企业抵制,而是建立明确的法律和社会规范,禁止滥用人工智能——类似于二战后反对核战争的规范。这需要持续的辩论,以及随着人工智能的发展而进行调整的意愿,认识到在人工智能驱动的世界中维护自由需要积极而深思熟虑的行动。