跳过主内容 补充剂研究与比较网站• 最低价保证 补充剂研究与比较网站 Pillser 注册 登录 研究动态 补充剂 品牌 益生菌 维生素 矿物质 问AI 新问题 做出关于您健康的明智决定 15.9K 补充剂 4.4K 研究论文 7.4K 健康结果 例如:维生素D β-胡萝卜素 胆固醇水平 提示:以“?”结尾触发AI回复 最低价保证 医疗声明 联盟披露 服务条款 隐私政策

## Kip:一种受语言学启发的编程语言 Kip 是一种实验性编程语言,探索语言学和类型论的交叉点,特别是利用土耳其语语法。它独特地将土耳其语名词格整合到其类型系统中,影响函数调用中参数的处理方式——只要格/类型不同,就可以灵活调整参数顺序。 Kip 不使用传统的语法,而是利用土耳其语形态学,包括格(主格、宾格、与格等)和元音和谐。它支持代数数据类型、泛型的类型变量、模式匹配和命名常量,所有这些都使用土耳其语语法表达。 Kip 并非用于生产环境;它是一种研究/教育工具。它包含用于整数和字符串的内置类型,以及基本运算和 I/O。该语言依赖于 TRmorph 工具包进行土耳其语形态分析,通过携带多个解析直到类型检查来处理歧义。 用户可以通过 REPL 探索 Kip,执行文件或生成 JavaScript 代码。一个浏览器游乐场也可用,从源代码构建。该项目正在积极开发中,因此语法和行为可能会发生变化。

客户端挑战:您的浏览器已禁用 JavaScript。请启用 JavaScript 以继续。网站的必要部分无法加载。这可能是由于浏览器扩展、网络问题或浏览器设置造成的。请检查您的连接,禁用任何广告拦截器,或尝试使用不同的浏览器。

## LLM 代理设计中的转变:Shells 取代工具 (2026年初) LLM 代理开发中的一个关键争论在于如何最好地为模型配备工具。 传统上,代理使用定义明确、细粒度的工具,但一种日益增长的趋势是利用 `exec_bash` 调用来利用现有的命令行界面 (CLI)。 这种方法受 Unix shell 命令组合的强大功能启发,具有显著的优势——通过管道降低 token 成本,可脚本化,以及对人类和机器都熟悉的界面。 作者通过访问 Google Docs & Groups 演示了这一点。 他们没有构建自定义代码,而是使用 `Restish` 来解释 Google 的 OpenAPI 规范,有效地将 API 文档转换为可执行命令。 OAuth 身份验证也使用 `oauth2c` 进行了简化,从而用简洁的 shell 脚本取代了数百行 Python 代码。 对于*没有*现成 API 的服务(如 Google Groups),作者成功地通过捕获浏览器中的网络流量、清理数据并提示 LLM 生成客户端来逆向工程 API。 这突显了 LLM 在缺乏官方 API 时弥合差距的潜力。 最终,作者提倡优先考虑 CLI 组合,认为它可以减少维护、最大限度地减少错误,并使个人能够使用最少的定制代码构建强大的代理。

德克萨斯州总检察长肯·帕克斯顿正在启动一项调查,调查可能影响儿童疫苗接种建议的财务激励措施。调查将审查儿科医生、保险公司(如UnitedHealthcare)和疫苗公司(包括辉瑞),以寻找未公开的奖金和可能迫使家长的行为。

《大纪元时报》的调查显示,保险公司曾向医生提供每接种一个儿童高达400美元的奖励,并且据报道,一些儿科医生解雇了拒绝接种疫苗的家庭。帕克斯顿旨在揭露任何医疗建议“受财务激励驱动”的利益冲突。

美国儿科学会坚称医生并未从疫苗中获利,他们的动机是安全性和有效性,而儿童健康防御组织(目前正在起诉美国儿科学会)则赞扬了这项调查。帕克斯顿此前曾调查过辉瑞(案件已驳回)和牙膏制造商,表明他一贯审查行业惯例。他希望确保德克萨斯州居民对医疗保健提供者的建议充满信心。

德克萨斯州总检察长肯·帕克斯顿正在启动一项调查,调查可能影响儿童疫苗接种建议的财务激励措施。调查将审查儿科医生、保险公司(如UnitedHealthcare)和疫苗公司(包括辉瑞),以寻找未公开的奖金和可能迫使家长的行为。

《大纪元时报》的调查显示,保险公司曾向医生提供每接种一个儿童高达400美元的奖励,并且据报道,一些儿科医生解雇了拒绝接种疫苗的家庭。帕克斯顿旨在揭露任何医疗建议“受财务激励驱动”的利益冲突。

美国儿科学会坚称医生并未从疫苗中获利,他们的动机是安全性和有效性,而儿童健康防御组织(目前正在起诉美国儿科学会)则赞扬了这项调查。帕克斯顿此前曾调查过辉瑞(案件已驳回)和牙膏制造商,表明他一贯审查行业惯例。他希望确保德克萨斯州居民对医疗保健提供者的建议充满信心。

请启用 JavaScript 并禁用任何广告拦截器。

查尔斯·休·史密斯认为,当权者并非通过真正解决方案来维持控制,而是通过**叙事控制**——通过将问题构建为虚假的“我们 vs. 他们”二元对立来操纵公众认知。这种策略通过利用我们天生的部落主义来绕过理性思考,迫使个人严格地与狭隘定义的群体(“保守派”或“自由派”)保持一致,并妖魔化 opposing 的观点。

细微差别和独立思考被压制;对群体任何既定立场的异议都会导致排斥。这种人为制造的冲突旨在团结支持并执行一项有利于少数人的议程。

史密斯认为,这种体制最终会导致一个空洞的文化和经济,建立在“超加工生活”之上——一种自私的虚构,质疑叙事会招致报复。 讽刺的是,策划这种控制的人们对它的破坏性后果视而不见,未能意识到他们虚假的 choices 会产生虚假的信号,最终导致系统崩溃。

查尔斯·休·史密斯认为,当权者并非通过真正解决方案来维持控制,而是通过**叙事控制**——通过将问题构建为虚假的“我们 vs. 他们”二元对立来操纵公众认知。这种策略通过利用我们天生的部落主义来绕过理性思考,迫使个人严格地与狭隘定义的群体(“保守派”或“自由派”)保持一致,并妖魔化 opposing 的观点。

细微差别和独立思考被压制;对群体任何既定立场的异议都会导致排斥。这种人为制造的冲突旨在团结支持并执行一项有利于少数人的议程。

史密斯认为,这种体制最终会导致一个空洞的文化和经济,建立在“超加工生活”之上——一种自私的虚构,质疑叙事会招致报复。 讽刺的是,策划这种控制的人们对它的破坏性后果视而不见,未能意识到他们虚假的 choices 会产生虚假的信号,最终导致系统崩溃。

在明尼苏达州发生涉及索马里移民的大规模欺诈丑闻后,特朗普总统和白宫表示希望迅速取消这些犯过罪的移民的公民身份并将其驱逐出境。然而,现行法律将取消公民身份限制在入籍过程中存在欺诈或虚假陈述的情况下,需要大量证据和漫长的法律斗争。

为了解决这个问题,埃里克·施密特参议员(共和党,密苏里州)提出了一项名为“SCAM法案”的法案。该法案将允许在入籍后的10年内,对那些因特定罪行(如超过1万美元的福利欺诈、严重重罪或加入恐怖组织,包括帮派和贩毒集团)而被定罪的人取消公民身份并驱逐出境。该法案还扩大了启动取消公民身份程序的理由,不再仅限于最初的申请欺诈。

白宫强烈支持“SCAM法案”,认为索马里欺诈是一个重大问题,并主张对欺诈移民采取立即行动。施密特认为,这起丑闻仅仅是个开始,在新冠疫情期间的资金中可能还会发现更多的欺诈行为。

在明尼苏达州发生涉及索马里移民的大规模欺诈丑闻后,特朗普总统和白宫表示希望迅速取消这些犯过罪的移民的公民身份并将其驱逐出境。然而,现行法律将取消公民身份限制在入籍过程中存在欺诈或虚假陈述的情况下,需要大量证据和漫长的法律斗争。

为了解决这个问题,埃里克·施密特参议员(共和党,密苏里州)提出了一项名为“SCAM法案”的法案。该法案将允许在入籍后的10年内,对那些因特定罪行(如超过1万美元的福利欺诈、严重重罪或加入恐怖组织,包括帮派和贩毒集团)而被定罪的人取消公民身份并驱逐出境。该法案还扩大了启动取消公民身份程序的理由,不再仅限于最初的申请欺诈。

白宫强烈支持“SCAM法案”,认为索马里欺诈是一个重大问题,并主张对欺诈移民采取立即行动。施密特认为,这起丑闻仅仅是个开始,在新冠疫情期间的资金中可能还会发现更多的欺诈行为。

这篇文章不是关于*腌制*鱼类,而是**保全·菲什**——一位1766年出生于纽约的人,拥有一个非常不寻常的名字。作为政治显赫的菲什家族成员,保全最初通过捕鲸和航运积累财富,后来又参与了早期的纽约证券交易所和银行业务。

尽管他的名字引起了许多人的有趣反应(甚至激发了船只之间的玩笑交流!),保全·菲什仍然是19世纪纽约的重要人物。他甚至短暂地控制了强大的民主党政治机器“塔曼尼厅”,并成功地抵御了被称为“火车头派”的改革者团体。

“火车头派”在与菲什的斗争中获得了这个名字,他们对黑暗的会场用自燃火柴做出回应——这个名字源于对“火车头”一词的误解。作为那个时代典型的成功商人,保全·菲什的故事突出了塑造早期纽约历史的那些色彩鲜明的人物。

这篇文章不是关于*腌制*鱼类,而是**保全·菲什**——一位1766年出生于纽约的人,拥有一个非常不寻常的名字。作为政治显赫的菲什家族成员,保全最初通过捕鲸和航运积累财富,后来又参与了早期的纽约证券交易所和银行业务。

尽管他的名字引起了许多人的有趣反应(甚至激发了船只之间的玩笑交流!),保全·菲什仍然是19世纪纽约的重要人物。他甚至短暂地控制了强大的民主党政治机器“塔曼尼厅”,并成功地抵御了被称为“火车头派”的改革者团体。

“火车头派”在与菲什的斗争中获得了这个名字,他们对黑暗的会场用自燃火柴做出回应——这个名字源于对“火车头”一词的误解。作为那个时代典型的成功商人,保全·菲什的故事突出了塑造早期纽约历史的那些色彩鲜明的人物。

杰克·史密斯最近在国会作证时,揭示了1月6日委员会调查中存在的问题,以及其对关键证人卡西迪·哈奇森的依赖。委员会主席吉姆·乔丹强调,委员会围绕哈奇森关于特朗普总统试图控制总统座驾的二手叙述,构建了一个戏剧性的故事——这一说法直接被当时在场的人否认。

史密斯在质询下承认,哈奇森的证词很大程度上是传闻,缺乏来自直接目击者的证实,包括特勤局特工。他甚至承认,在之前的证词中,如果需要反驳她的证词,他会寻求将其*排除*。尽管存在这些已知的可信度问题,1月6日委员会却大量使用了哈奇森的证词,而史密斯也没有排除在审判中使用她的可能性。

报道还显示,史密斯团队内部对哈奇森的可靠性存在疑虑,导致检察官建议不要使用她作为证人。这次交锋凸显了民主党人倾向于宣传轰动但未经证实的主张,而特别检察官则难以证实委员会的核心叙述。

杰克·史密斯最近在国会作证时,揭示了1月6日委员会调查中存在的问题,以及其对关键证人卡西迪·哈奇森的依赖。委员会主席吉姆·乔丹强调,委员会围绕哈奇森关于特朗普总统试图控制总统座驾的二手叙述,构建了一个戏剧性的故事——这一说法直接被当时在场的人否认。

史密斯在质询下承认,哈奇森的证词很大程度上是传闻,缺乏来自直接目击者的证实,包括特勤局特工。他甚至承认,在之前的证词中,如果需要反驳她的证词,他会寻求将其*排除*。尽管存在这些已知的可信度问题,1月6日委员会却大量使用了哈奇森的证词,而史密斯也没有排除在审判中使用她的可能性。

报道还显示,史密斯团队内部对哈奇森的可靠性存在疑虑,导致检察官建议不要使用她作为证人。这次交锋凸显了民主党人倾向于宣传轰动但未经证实的主张,而特别检察官则难以证实委员会的核心叙述。

## 世界最大的齿轮船在丹麦水域被发现

海洋考古学家在丹麦和瑞典之间的厄勒海峡发现了一艘已知世界上最大的齿轮船——一种中世纪货运船。这艘名为“斯瓦尔盖特2号”的船只建造于大约1410年,长28米,载货量约300吨。这一发现为了解中世纪晚期的贸易和造船业提供了前所未有的见解。

这艘保存异常完好的沉船揭示了罕见细节,包括幸存的索具和砖砌的厨房——在丹麦水域发现的最早的此类厨房,表明船员拥有更高水平的舒适度和组织性。木材分析表明,这艘船只在荷兰建造,使用的材料来自波美拉尼亚和荷兰,突显了复杂的供应链。

重要的是,“斯瓦尔盖特2号”提供了“城堡”——船首和船尾的升起平台——的第一个实物证据,此前这些平台仅在艺术作品中出现。该船只的尺寸表明,存在一个高度组织化的贸易体系,能够支持盐、木材和食物等大宗商品的运输。“斯瓦尔盖特2号”目前正在进行保护,并有望重塑我们对中世纪航运及其在北欧贸易中的作用的理解。

## 世界最大的齿轮船在丹麦水域被发现

海洋考古学家在丹麦和瑞典之间的厄勒海峡发现了一艘已知世界上最大的齿轮船——一种中世纪货运船。这艘名为“斯瓦尔盖特2号”的船只建造于大约1410年,长28米,载货量约300吨。这一发现为了解中世纪晚期的贸易和造船业提供了前所未有的见解。

这艘保存异常完好的沉船揭示了罕见细节,包括幸存的索具和砖砌的厨房——在丹麦水域发现的最早的此类厨房,表明船员拥有更高水平的舒适度和组织性。木材分析表明,这艘船只在荷兰建造,使用的材料来自波美拉尼亚和荷兰,突显了复杂的供应链。

重要的是,“斯瓦尔盖特2号”提供了“城堡”——船首和船尾的升起平台——的第一个实物证据,此前这些平台仅在艺术作品中出现。该船只的尺寸表明,存在一个高度组织化的贸易体系,能够支持盐、木材和食物等大宗商品的运输。“斯瓦尔盖特2号”目前正在进行保护,并有望重塑我们对中世纪航运及其在北欧贸易中的作用的理解。

## 解锁固件秘密,无需调试访问

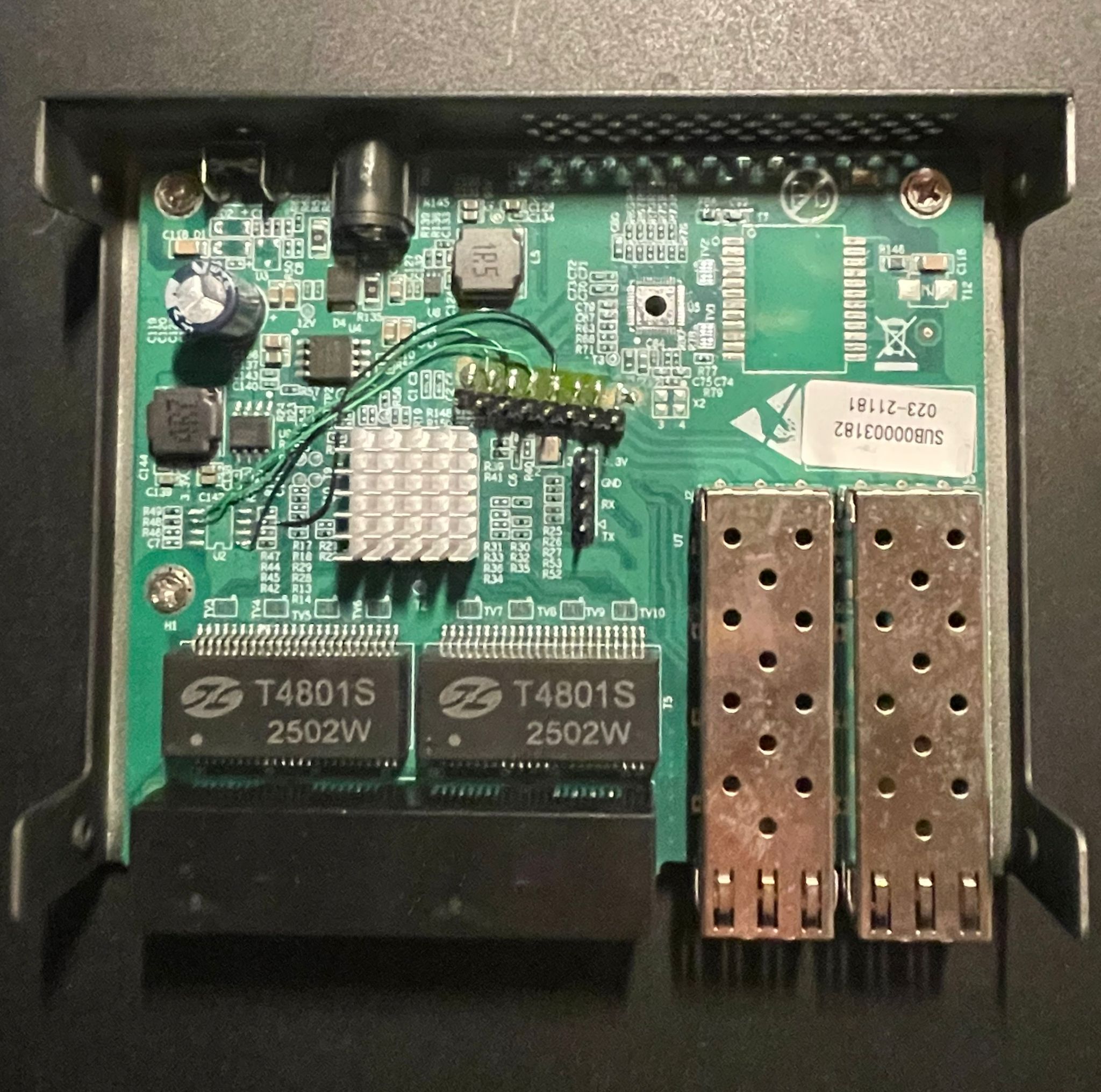

本文详细描述了一次成功从锁定状态的嵌入式设备——廉价的网管型交换机——中提取密码的尝试,即使没有传统的调试访问权限。作者利用设备外部SPI闪存的指令跟踪来理解固件的代码流程。

目标设备是一款基于瑞昱RTL8372N芯片的GoodTop GT-ST024M交换机,最初通过UART阻止了访问。由于无法直接调试,作者专注于存储在W25Q16JV QSPI闪存芯片上的固件,利用其XIP(就地执行)功能。通过使用SLogic16U3逻辑分析仪捕获SPI通信,他们创建了加载执行的指令跟踪。

8051架构的代码分段系统使得逆向工程变得复杂,而标准Ghidra工具对此不支持。开发了一个自定义加载脚本来处理这个问题,并分析指令跟踪以确定密码输入期间执行的代码段。这揭示了关键位置,最终在固件中发现了XOR加密的密码。然后,注入了一个小的代码片段,通过UART转储了解密的密码。

该项目突出了在无法调试时硬件级分析的力量,并展示了SLogic16U3作为一种可行且经济实惠的替代方案,可以替代更昂贵的逻辑分析仪,如Saleae Logic。它强调了动态观察和创造性问题解决能力可以克服嵌入式安全研究中的障碍。

## 解锁固件秘密,无需调试访问

本文详细描述了一次成功从锁定状态的嵌入式设备——廉价的网管型交换机——中提取密码的尝试,即使没有传统的调试访问权限。作者利用设备外部SPI闪存的指令跟踪来理解固件的代码流程。

目标设备是一款基于瑞昱RTL8372N芯片的GoodTop GT-ST024M交换机,最初通过UART阻止了访问。由于无法直接调试,作者专注于存储在W25Q16JV QSPI闪存芯片上的固件,利用其XIP(就地执行)功能。通过使用SLogic16U3逻辑分析仪捕获SPI通信,他们创建了加载执行的指令跟踪。

8051架构的代码分段系统使得逆向工程变得复杂,而标准Ghidra工具对此不支持。开发了一个自定义加载脚本来处理这个问题,并分析指令跟踪以确定密码输入期间执行的代码段。这揭示了关键位置,最终在固件中发现了XOR加密的密码。然后,注入了一个小的代码片段,通过UART转储了解密的密码。

该项目突出了在无法调试时硬件级分析的力量,并展示了SLogic16U3作为一种可行且经济实惠的替代方案,可以替代更昂贵的逻辑分析仪,如Saleae Logic。它强调了动态观察和创造性问题解决能力可以克服嵌入式安全研究中的障碍。

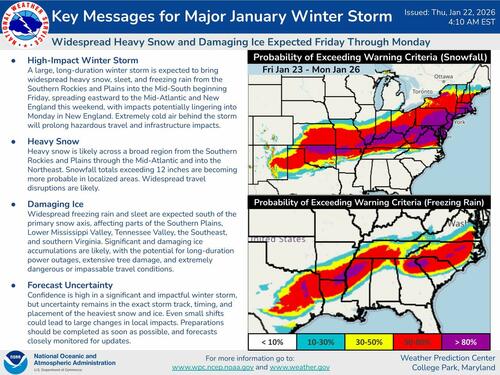

一场历史性的冬季风暴预计将从周五到周一影响美国大约三分之二的地区——约2.3亿人,范围跨越从亚利桑那州到东北部的33个州。 尽管关于气候变化的讨论仍在继续,但危险的极地寒流和冬季风暴弗恩正准备带来大量降雪、冰冻以及可能导致瘫痪的条件。

主要威胁不仅仅是降雪;一场大范围的冰暴正在形成,尤其是在从德克萨斯州到卡罗来纳州的南部地区。 预计冰层积聚可达四分之三英寸,可能导致大范围停电和严重的树木损坏。 阿肯色州、密西西比州和田纳西州的部分地区正在为特别严重的冰冻做准备。

德克萨斯州居民已经开始为潜在的交通中断和电网问题做准备,并记住了2021年的ERCOT崩溃事件。 此外,人们还担心阿巴拉契亚地区的天然气生产中断会影响更北方的电网。 居民们被敦促为风暴过后可能需要数天的恢复工作做好准备。

一场历史性的冬季风暴预计将从周五到周一影响美国大约三分之二的地区——约2.3亿人,范围跨越从亚利桑那州到东北部的33个州。 尽管关于气候变化的讨论仍在继续,但危险的极地寒流和冬季风暴弗恩正准备带来大量降雪、冰冻以及可能导致瘫痪的条件。

主要威胁不仅仅是降雪;一场大范围的冰暴正在形成,尤其是在从德克萨斯州到卡罗来纳州的南部地区。 预计冰层积聚可达四分之三英寸,可能导致大范围停电和严重的树木损坏。 阿肯色州、密西西比州和田纳西州的部分地区正在为特别严重的冰冻做准备。

德克萨斯州居民已经开始为潜在的交通中断和电网问题做准备,并记住了2021年的ERCOT崩溃事件。 此外,人们还担心阿巴拉契亚地区的天然气生产中断会影响更北方的电网。 居民们被敦促为风暴过后可能需要数天的恢复工作做好准备。

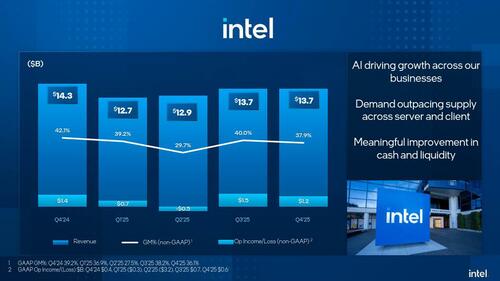

## 英特尔财报令人失望,股价下跌

英特尔最近的财报引发了盘后股价下跌,尽管在很大程度上*符合*或*略高于*第四季度的预期。营收达到136.7亿美元(同比下降4.1%),数据中心与人工智能和代工厂业务营收有所增长,而客户端计算业务未达到预期。调整后的毛利率大幅下降至37.9%,但仍高于预期。

然而,核心问题在于英特尔疲弱的下季度(Q1)指引。该公司预测营收将在117亿至127亿美元之间——低于分析师预期——并预计亏损,调整后的每股收益为0美元。毛利率预计也将进一步降至34.5%。

英特尔将令人失望的前景归因于供应链问题,这些问题阻碍了他们满足强劲需求的能力,尽管他们控制着自己的制造。分析师指出,持续的制造良率问题——生产的可用芯片比率——才是真正的罪魁祸首。尽管美国政府、英伟达和软银进行了大量投资,并推出了新产品,英特尔仍然离其营收峰值很远,并且难以与AMD和高通竞争。财报发布后,股价下跌了5%,表明投资者担心根本性的改进仍然难以实现。

## 英特尔财报令人失望,股价下跌

英特尔最近的财报引发了盘后股价下跌,尽管在很大程度上*符合*或*略高于*第四季度的预期。营收达到136.7亿美元(同比下降4.1%),数据中心与人工智能和代工厂业务营收有所增长,而客户端计算业务未达到预期。调整后的毛利率大幅下降至37.9%,但仍高于预期。

然而,核心问题在于英特尔疲弱的下季度(Q1)指引。该公司预测营收将在117亿至127亿美元之间——低于分析师预期——并预计亏损,调整后的每股收益为0美元。毛利率预计也将进一步降至34.5%。

英特尔将令人失望的前景归因于供应链问题,这些问题阻碍了他们满足强劲需求的能力,尽管他们控制着自己的制造。分析师指出,持续的制造良率问题——生产的可用芯片比率——才是真正的罪魁祸首。尽管美国政府、英伟达和软银进行了大量投资,并推出了新产品,英特尔仍然离其营收峰值很远,并且难以与AMD和高通竞争。财报发布后,股价下跌了5%,表明投资者担心根本性的改进仍然难以实现。

枪支行业在第二次特朗普政府的第一年经历了繁荣,2024年为美国经济贡献了916.5亿美元,比2008年增长了近400%。行业领导者预计随着潜在的联邦监管放松,将进一步增长,促使共和党州长积极加强枪支所有者的权利。

在拉斯维加斯的SHOT Show上,像南达科他州州长拉里·罗登这样的人呼吁迅速解决诸如消音器放松管制和州际贸易等问题。特朗普政府通过白宫顾问大卫·沃灵顿表示致力于加强第二修正案权利,包括简化枪支销售,并可能要求在枪支表格上进行生物性别识别。

州长们还积极招揽寻求从监管更严格的州搬迁的枪支制造商,强调该行业带来的经济效益——高工资、大量税收贡献和熟练就业机会的创造。一个关键的挑战是熟练劳动力短缺,导致各州投资于职业培训项目以满足行业需求。国家射击运动基金会是华盛顿最大的枪支权利游说团体,在游说活动上花费数百万美元。

枪支行业在第二次特朗普政府的第一年经历了繁荣,2024年为美国经济贡献了916.5亿美元,比2008年增长了近400%。行业领导者预计随着潜在的联邦监管放松,将进一步增长,促使共和党州长积极加强枪支所有者的权利。

在拉斯维加斯的SHOT Show上,像南达科他州州长拉里·罗登这样的人呼吁迅速解决诸如消音器放松管制和州际贸易等问题。特朗普政府通过白宫顾问大卫·沃灵顿表示致力于加强第二修正案权利,包括简化枪支销售,并可能要求在枪支表格上进行生物性别识别。

州长们还积极招揽寻求从监管更严格的州搬迁的枪支制造商,强调该行业带来的经济效益——高工资、大量税收贡献和熟练就业机会的创造。一个关键的挑战是熟练劳动力短缺,导致各州投资于职业培训项目以满足行业需求。国家射击运动基金会是华盛顿最大的枪支权利游说团体,在游说活动上花费数百万美元。

## 从创始人到销售:一年的学习 本文详细讲述了一位技术创始人意识到客户获取是建立可持续SaaS业务的最大障碍后,进入销售领域的故事。起初犹豫不决,这位创始人深入研究B2B销售,甚至共同创立了一家代理/SaaS混合公司(Ibex),专注于客户获取。 关键在于,营销可能适用于低成本、生活方式型企业,但高接触销售——包括个性化沟通甚至产品定制——对于雄心勃勃的增长和更高的收入至关重要。这个过程需要通过实验和迭代来定义理想客户画像(ICP),并了解销售漏斗的阶段(TOFU、MOFU、BOFU)以及现实的转化率。 领英证明是一个有价值的潜在客户生成工具,它提供了意向信号和比冷邮件更高的信任度。成功的电话沟通以真实性和提问为中心,而不是强行建立融洽关系。最终,这位创始人发现销售不仅仅是完成交易,而是产品开发和市场理解的重要反馈循环,将不适转化为强大的增长引擎。

## CoreML-CLI:Core ML 模型命令行工具 CoreML-CLI 是一个 macOS 原生命令行界面,用于与 Apple 的 Core ML 模型交互,无需 Xcode 或 Python。它允许用户**检查**模型结构和元数据,**运行推理**(预测)各种数据类型(图像、文本、JSON),**基准测试**性能,**编译**模型以进行优化,以及**管理**元数据。 **主要特性:** * **检查:** 查看模型详情,如输入、输出和作者信息。 * **预测:** 在单个文件或数据目录上**批量处理**运行推理。支持指定计算设备(CPU、GPU、Apple Neural Engine)。 * **基准测试:** 使用可定制的迭代次数测量推理延迟和吞吐量。 * **编译:** 将 `.mlmodel` 文件转换为优化的 `.mlmodelc` 格式。 * **元数据管理:** 查看和管理模型元数据。 **安装:** 通过 `brew` (`brew tap schappim/coreml-cli brew install coreml-cli`) 或从 GitHub Releases 直接下载。需要 macOS 13+ 和 Swift 5.9+。 **示例用法:** `coreml predict MobileNetV2.mlmodel --input photo.jpg` 或 `coreml benchmark MobileNetV2.mlmodel --input sample.jpg`。输出可以格式化为 JSON,用于脚本编写和 CI/CD 集成。

我们检测到您的浏览器已禁用 JavaScript。请启用 JavaScript 或切换到受支持的浏览器以继续使用 x.com。您可以在我们的帮助中心查看受支持的浏览器列表。帮助中心 服务条款 隐私政策 Cookie 政策 版权信息 广告信息 © 2026 X Corp.

## 一个十字路口上的国家

近期关于美国可能爆发内战的讨论源于一个令人担忧的趋势:即移民被视为用于政治控制的武器,这呼应了罗马、西班牙和苏联等帝国所采用的“殖民者殖民主义”的历史策略。这些策略涉及旨在削弱现有国家认同并巩固政治权力的demographic shifts(人口结构变化)。

美国历史上欢迎移民,但在唐纳德·特朗普总统任期后发生了转变。随着移民涌入,人们对选举公正性的担忧日益增加,尤其是在2020年关于邮寄选票的争议。许多人认为,现任政府正在通过放宽移民政策、提供福利,以及可能影响投票模式来故意改变选民结构。

这加剧了对民主进程的不信任,并引发了对社会契约——由人民组成的政府——根本性破裂的担忧。目前在明尼苏达州等州发生的冲突,抗议活动阻碍了移民执法,凸显了这种更深层次的紧张关系。

作者认为,对公民身份和投票权的明确共识对于维护共和国至关重要。 否则,慷慨的福利、可疑的投票标准和势均力敌的选举的混合,可能会加剧紧张局势,并可能危及美国的自由。

## 一个十字路口上的国家

近期关于美国可能爆发内战的讨论源于一个令人担忧的趋势:即移民被视为用于政治控制的武器,这呼应了罗马、西班牙和苏联等帝国所采用的“殖民者殖民主义”的历史策略。这些策略涉及旨在削弱现有国家认同并巩固政治权力的demographic shifts(人口结构变化)。

美国历史上欢迎移民,但在唐纳德·特朗普总统任期后发生了转变。随着移民涌入,人们对选举公正性的担忧日益增加,尤其是在2020年关于邮寄选票的争议。许多人认为,现任政府正在通过放宽移民政策、提供福利,以及可能影响投票模式来故意改变选民结构。

这加剧了对民主进程的不信任,并引发了对社会契约——由人民组成的政府——根本性破裂的担忧。目前在明尼苏达州等州发生的冲突,抗议活动阻碍了移民执法,凸显了这种更深层次的紧张关系。

作者认为,对公民身份和投票权的明确共识对于维护共和国至关重要。 否则,慷慨的福利、可疑的投票标准和势均力敌的选举的混合,可能会加剧紧张局势,并可能危及美国的自由。

一个统一了AI视频、图像、语音和音乐生成的TypeScript SDK。与其学习五个不同的SDK,不如学习一个。它带有独特的JSX语法,用于声明式地组合视频——编写<Clip>、<Image>、<Speech>即可获得渲染后的MP4。

## 从沮丧到实用的应用程序:LLM 为定制软件赋能

一位家长因每日通勤和停车罚单而感到沮丧,由此引发了一个此前被认为过于耗时的项目:一个实时停车限制应用程序。尽管精通技术的的朋友们一再保证数据唾手可得,但没有人有精力去构建它——直到现在。

利用像 Claude 和 Opus 这样的 LLM,作者在几天内迅速原型设计并构建了一个可用的网络应用程序。这次经历凸显了一种向易于访问的“定制化”软件转变,其中 LLM 作为强大的力量倍增器,高效地处理复杂的编码任务和研究。

该项目涉及数据获取、预处理(将 50MB 的数据集缩小到可管理的大小)和前端开发。LLM 不仅生成代码,还巧妙地管理模式更改和优化,例如切换到自定义坐标系以提高性能。最终产品拥有轻量级前端(小于 200kb)和高效更新数据的后端。

这一成功表明 LLM 有潜力 democratize 软件创建,使个人能够解决由于高“激活能量”和持续维护而以前不切实际的“周末项目”范围。

## 从沮丧到实用的应用程序:LLM 为定制软件赋能

一位家长因每日通勤和停车罚单而感到沮丧,由此引发了一个此前被认为过于耗时的项目:一个实时停车限制应用程序。尽管精通技术的的朋友们一再保证数据唾手可得,但没有人有精力去构建它——直到现在。

利用像 Claude 和 Opus 这样的 LLM,作者在几天内迅速原型设计并构建了一个可用的网络应用程序。这次经历凸显了一种向易于访问的“定制化”软件转变,其中 LLM 作为强大的力量倍增器,高效地处理复杂的编码任务和研究。

该项目涉及数据获取、预处理(将 50MB 的数据集缩小到可管理的大小)和前端开发。LLM 不仅生成代码,还巧妙地管理模式更改和优化,例如切换到自定义坐标系以提高性能。最终产品拥有轻量级前端(小于 200kb)和高效更新数据的后端。

这一成功表明 LLM 有潜力 democratize 软件创建,使个人能够解决由于高“激活能量”和持续维护而以前不切实际的“周末项目”范围。

最近一次网络讨论,源于2007年的一条网评,将人们划分为“请求者”和“猜测者”——这是两种不同的社交请求方式。“请求者”直接提出自己的需求,并接受可能的拒绝,而“猜测者”则依赖微妙的暗示和共同的期望,避免直接请求以防止尴尬。 争论的中心在于哪种方式更礼貌或更有效。一些人认为“猜测文化”滋生模糊和沮丧,提倡直接请求的清晰度。另一些人则认为“猜测文化”优先考虑礼貌,避免强加于人。 这种区分不仅仅是关于礼仪,它还会影响个人、职业甚至国际关系。当“请求者”和“猜测者”互动时,可能会产生误解,直接请求在“猜测者”看来可能显得唐突。最终,这场讨论强调了沟通方式存在于一个连续统上,适应情境和对方是关键。

数据类型 温度 降雨 光照 温度类型 平均值 体感温度 最高值 平均值 最低值 拖动旋转3D图

## 超越智能代码检查:一种基于系统的AI代码审查方法

当前的AI代码审查工具往往模仿代码检查器,提供大量注释,却无法理解代码的意图或更广泛的背景。为了真正模拟资深工程师,AI审查需要一种系统性的方法——结合专业能力,而不是依赖于单个强大的模型。

Qodo的系统优先考虑**思维一致性**,首先通过PR描述、关联问题和提交历史来理解更改的*原因*。这种背景信息会告知后续分析,由专注于安全、性能或架构等领域的专业“专家”代理并行运行。

一个中央**协调器**激活相关的专家,一个**仲裁者**综合他们的发现,过滤团队特定的优先级并解决冲突。这避免了向开发者提供过多干扰,只提供可操作的见解。

至关重要的是,该系统从过去的PR中学习,构建一个**组织知识层**来理解历史决策和模式。这使得AI能够提供上下文相关的反馈,适应团队独特的代码库和偏好。

最终,Qodo旨在创建一个代码审查平台,它不仅*发现*问题,而且*理解*问题——以知情、专注和个性化的反馈参与代码库的演进。

## 超越智能代码检查:一种基于系统的AI代码审查方法

当前的AI代码审查工具往往模仿代码检查器,提供大量注释,却无法理解代码的意图或更广泛的背景。为了真正模拟资深工程师,AI审查需要一种系统性的方法——结合专业能力,而不是依赖于单个强大的模型。

Qodo的系统优先考虑**思维一致性**,首先通过PR描述、关联问题和提交历史来理解更改的*原因*。这种背景信息会告知后续分析,由专注于安全、性能或架构等领域的专业“专家”代理并行运行。

一个中央**协调器**激活相关的专家,一个**仲裁者**综合他们的发现,过滤团队特定的优先级并解决冲突。这避免了向开发者提供过多干扰,只提供可操作的见解。

至关重要的是,该系统从过去的PR中学习,构建一个**组织知识层**来理解历史决策和模式。这使得AI能够提供上下文相关的反馈,适应团队独特的代码库和偏好。

最终,Qodo旨在创建一个代码审查平台,它不仅*发现*问题,而且*理解*问题——以知情、专注和个性化的反馈参与代码库的演进。

Please provide the content you want me to translate. I need the text to be able to translate it to Chinese. Just paste it here, and I will give you the Chinese translation.

## 美国赔偿的历史与不切实际 自20世纪60年代以来,针对美国黑人的赔偿要求——源于奴隶制和吉姆·克劳政策——不断浮现,呼吁从白人和经济成功群体中进行财富再分配。早期的呼吁,如黑豹党的呼吁,侧重于保证收入或没收生产资料。最近,像塔-内希西·科茨这样的作家记录了系统性歧视,强调了土地掠夺和红线政策等歧视性做法,这些做法阻碍了黑人财富的积累。 尽管普遍支持承认过去的 injustices,具体的赔偿计划面临着重大障碍。提议范围从研究(HR 40)到像伊利诺伊州埃文斯顿镇的有限住房援助等本地化项目,以及像旧金山提出的500万美元支付计划这样雄心勃勃但最终不切实际的计划。加州的工作组面临着州长的否决。 目前的提议在很大程度上类似于扩大的福利计划,提供学生贷款减免或住房补贴,而不是促进真正的世代财富。批评者,包括默里·罗斯巴德,认为真正的赔偿将涉及土地再分配——赋予前奴隶生产资料。最终,大多数提议计划的规模在财政上不可持续,可能导致负面经济后果,而无法实现持久的财富公平。

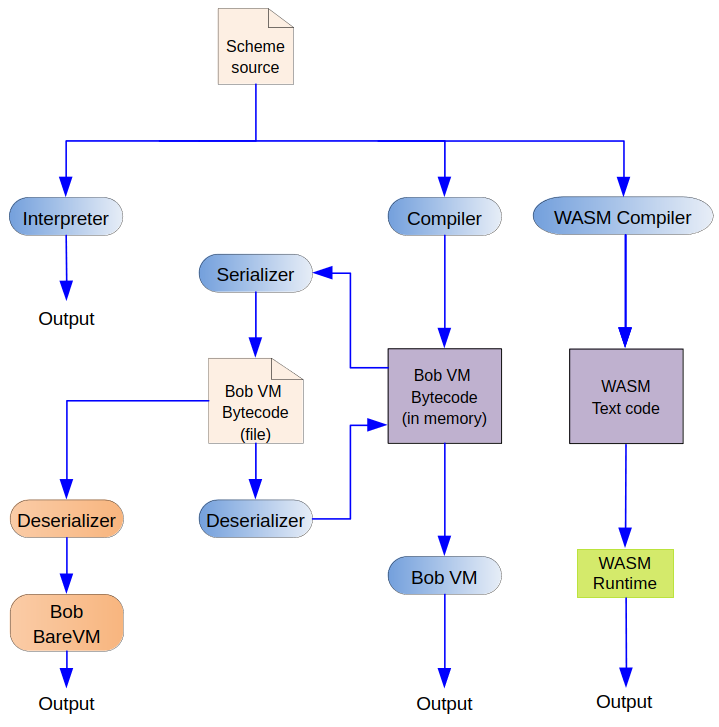

## Bob 项目更新:Scheme 到 WebAssembly

开源项目 Bob,一套用 Python 实现的 Scheme 语言工具集,最近庆祝了它的 15 周年。最初创建 Bob 是为了探索字节码虚拟机,现在它包含了 Python 和 C++ 中的解释器、编译器和虚拟机。开发者最近添加了一个新的编译器,能够将 Scheme 直接编译到 WebAssembly (WASM)。

此举旨在解决将具有垃圾回收和闭包等特性的高级语言编译到 WASM 的复杂性,并获得使用 WASM GC 扩展的实践经验。该项目成功地在 WASM 环境中表示 Scheme 对象,如对、布尔值和符号,利用 WASM GC 进行内存管理,并使用线性内存进行字符串表示。

主要挑战包括实现 `write` 函数,以便在 WASM 文本中直接输出 Scheme 值,最终借助了 AI 的帮助。WASM 编译器依赖于两个宿主函数进行基本输出,保持核心逻辑自包含。生成的编译器大约有 1000 行代码(其中很大一部分是生成的 WASM 文本),提供了一个关于实际代码发射到 WASM 的良好示例。

## Bob 项目更新:Scheme 到 WebAssembly

开源项目 Bob,一套用 Python 实现的 Scheme 语言工具集,最近庆祝了它的 15 周年。最初创建 Bob 是为了探索字节码虚拟机,现在它包含了 Python 和 C++ 中的解释器、编译器和虚拟机。开发者最近添加了一个新的编译器,能够将 Scheme 直接编译到 WebAssembly (WASM)。

此举旨在解决将具有垃圾回收和闭包等特性的高级语言编译到 WASM 的复杂性,并获得使用 WASM GC 扩展的实践经验。该项目成功地在 WASM 环境中表示 Scheme 对象,如对、布尔值和符号,利用 WASM GC 进行内存管理,并使用线性内存进行字符串表示。

主要挑战包括实现 `write` 函数,以便在 WASM 文本中直接输出 Scheme 值,最终借助了 AI 的帮助。WASM 编译器依赖于两个宿主函数进行基本输出,保持核心逻辑自包含。生成的编译器大约有 1000 行代码(其中很大一部分是生成的 WASM 文本),提供了一个关于实际代码发射到 WASM 的良好示例。

一项对85项研究的新回顾表明,就大脑健康而言,并非所有坐姿都是一样的。研究人员区分了“主动式”坐姿——例如阅读、玩牌或使用电脑——和“被动式”坐姿,例如看电视。

虽然*总*坐姿时间与认知能力下降有关,但“主动式”坐姿却显示出与认知功能有压倒性的*积极*关联,改善了记忆力和执行功能。相反,“被动式”坐姿始终与*负面*结果相关,包括更高的痴呆症风险。

关键区别在于精神参与度;主动式坐姿刺激大脑,而被动式坐姿则不然。研究人员希望这一发现能将健康建议从简单地“少坐”转变为鼓励在*坐着*时进行精神刺激活动,从而提供一种现实的方式来支持长期的脑部健康并可能降低痴呆症风险。锻炼仍然至关重要,但大脑锻炼并不总是意味着站起来活动。

一项对85项研究的新回顾表明,就大脑健康而言,并非所有坐姿都是一样的。研究人员区分了“主动式”坐姿——例如阅读、玩牌或使用电脑——和“被动式”坐姿,例如看电视。

虽然*总*坐姿时间与认知能力下降有关,但“主动式”坐姿却显示出与认知功能有压倒性的*积极*关联,改善了记忆力和执行功能。相反,“被动式”坐姿始终与*负面*结果相关,包括更高的痴呆症风险。

关键区别在于精神参与度;主动式坐姿刺激大脑,而被动式坐姿则不然。研究人员希望这一发现能将健康建议从简单地“少坐”转变为鼓励在*坐着*时进行精神刺激活动,从而提供一种现实的方式来支持长期的脑部健康并可能降低痴呆症风险。锻炼仍然至关重要,但大脑锻炼并不总是意味着站起来活动。