启用 JavaScript 和 Cookie 以继续。

每日HackerNews RSS

## 全同态加密因英特尔Heracles芯片而提速 对使用云端人工智能时数据隐私的担忧正在推动**全同态加密 (FHE)** 领域的创新——这种方法允许在不解密的情况下对加密数据进行计算。然而,历史上FHE的速度一直非常慢,通常比传统计算慢数千倍。 英特尔最近推出了**Heracles**,这是一款专门设计的芯片,旨在克服这一障碍。在最近的一次会议上展示,Heracles在FHE任务中实现了高达**5000倍的速度提升**,与标准的英特尔CPU相比。性能的飞跃归功于其庞大的尺寸(比其他研究芯片大20倍)、先进的3纳米技术和巨大的内存容量。 虽然几家初创公司也在开发FHE加速器,但英特尔认为Heracles是目前可扩展性和功能最强大的硬件。该芯片擅长处理FHE中固有的复杂数学运算和海量数据,为安全投票以及关键的**加密人工智能和机器学习**等应用提供显著优势。 尽管商业化时间表仍不明确,但Heracles代表着通向实用、保护隐私的计算迈出了重要一步,为未来铺平了道路,在未来,敏感数据可以在云端安全地处理。

新的美国法律旨在保护未成年人在网上,却意外地影响了成年用户,要求对更广泛的平台(从社交媒体到成人内容)进行年龄验证。大约一半的美国州正在制定这些法律,迫使公司筛查所有用户,引发了隐私担忧和对互联网日益封闭的担忧。 验证方法各不相同,从人工智能驱动的面部分析到完整的身份证扫描,通常由第三方供应商处理。虽然公司旨在平衡安全与用户体验,但许多用户抵制提交敏感数据,如自拍照或身份证,导致延误(如Discord的推出)和潜在的规避方法,如使用预付卡。 一个主要担忧是这些数据会去哪里——供应商可能会保留信息长达三年,从而产生潜在的安全风险(最近的数据泄露事件已凸显),并引发关于政府访问权限的问题。倡导者警告说,这会集中敏感数据并侵蚀在线隐私。法律诉讼正在进行中,一些法律已经面临第一修正案的挑战。行业专家预测,将朝着“持久验证”方向发展——一种跨多个平台使用的单一数字年龄证明——使身份检查成为在线生活的永久组成部分。

## Caxlsx:Ruby Excel 电子表格生成

Caxlsx(前身为 Axlsx)是一个 Ruby gem,用于生成 Excel (.xlsx) 电子表格。它允许开发者创建包含图表、图像、公式、自定义样式等复杂文档,而无需深入了解 Office Open XML 规范。

主要特性包括自动数据类型检测、灵活的列宽控制、对各种图表类型(3D 饼图、折线图、柱状图等)的支持,以及对单元格、行和整个工作簿的强大样式选项。Caxlsx 优先保证文档有效性,并与 Google Docs、LibreOffice 和 Numbers 等软件具有互操作性(存在一些限制)。

**重要更新:** 该项目已被分叉,现在由社区组织 **Caxlsx** ([https://github.com/caxlsx](https://github.com/caxlsx)) 维护。相关的 gem 也已迁移到那里。鼓励用户加入 Caxlsx Slack 频道以获取支持。

详细文档和示例可在网上和 gem 本身内找到。安全性通过默认公式转义来解决,可以根据需要进行配置。

您的IP地址已被Codeberg屏蔽。如果您认为这是一个错误,请通过contact us联系我们,并提供您的IP地址:47.245.80.60

## FreeBSD 14.4-RELEASE 发布 FreeBSD 14.4-RELEASE 现已发布,支持多种架构,包括 amd64、i386、aarch64 等。安装方式包括可引导 ISO 镜像、网络安装或 USB 存储设备。提供多种镜像类型: * **dvd1:** 完整安装,包含软件包和救援模式。 * **disc1:** 基础操作系统,救援模式,不包含软件包。 * **bootonly/mini-memstick:** 启动后需要网络安装。 * **memstick:** 通过 USB 完整安装。 * **SD 卡镜像:** 专为 ARM 系统设计,包含预配置的用户账户以便通过 SSH 访问。 针对 amd64、i386、AArch64 和 RISCV 架构,还提供预构建的虚拟机镜像(QCOW2、VHD、VMDK、raw)。此外,FreeBSD 14.4-RELEASE 可通过提供的 AMI ID 和市场列表轻松部署在 AWS 和 Google Cloud 平台上。 提供校验和(SHA512 & SHA256)以及经过 PGP 签名的公告版本,用于验证。详细说明,包括创建可引导 USB 驱动器的 `dd` 命令示例,包含在发布文档中。

``` ldr pc,reset_handler_ptr ;@ 处理器复位处理程序 ldr pc,undefined_handler_ptr ;@ 未定义指令处理程序 ldr pc,swi_handler_ptr ;@ 软件中断 ldr pc,prefetch_handler_ptr ;@ 预取/中止处理程序 ldr pc,data_handler_ptr ;@ 数据中止处理程序 ldr pc,unused_handler_ptr ;@ ldr pc,irq_handler_ptr ;@ IRQ处理程序 ldr pc,fiq_handler_ptr ;@ 快速中断处理程序 ;@ 设置分支地址 reset_handler_ptr: .word reset undefined_handler_ptr: .word hang swi_handler_ptr: .word hang prefetch_handler_ptr: .word hang data_handler_ptr: .word hang unused_handler_ptr: .word hang irq_handler_ptr: .word irq_handler fiq_handler_ptr: .word hang reset: ;@ 禁止中断 cpsid if ;@ 将中断向量复制到其位置 ldr r0,=_entry mov r1,#0x0000 ;@ 这里我们复制分支指令 ldmia r0!,{r2,r3,r4,r5,r6,r7,r8,r9} stmia r1!,{r2,r3,r4,r5,r6,r7,r8,r9} ;@ 这里我们复制分支地址 ldmia r0!,{r2,r3,r4,r5,r6,r7,r8,r9} stmia r1!,{r2,r3,r4,r5,r6,r7,r8,r9} ```

客户端挑战:您的浏览器已禁用 JavaScript。请启用 JavaScript 以继续。网站的必要部分无法加载。这可能是由于浏览器扩展、网络问题或浏览器设置造成的。请检查您的连接,禁用任何广告拦截器,或尝试使用不同的浏览器。

## Felix 的十年自我追踪:总结

过去十年,Felix 细致地追踪了他生活中的 100 多个方面——从健身和睡眠到电脑使用和旅行——积累了近 38 万个数据点。出于对不同生活因素之间相互联系的好奇,他构建了一个完全开源的平台 howisFelix.today,以可视化这些数据。

主要来源包括 RescueTime(电脑活动)、Foursquare Swarm(位置)以及手动输入的情绪、健康等数据。分析显示,幸福感与生产力提高之间存在相关性,天气对活动的影响,以及酒精和睡眠对静息心率的影响。

他发现了旅行中的规律(周日航班、常用路线),COVID 封锁对他的生活方式的影响(更多通话、更健康习惯),以及位置对步数的影响(在纽约走得更多)。虽然这个项目耗费了大量时间,但 Felix 获得了宝贵的自我意识和见解,最终认为这项努力可能不值得他人复制。他现在正在归档这个项目,但会保留网站以展示他对生活数据驱动探索。

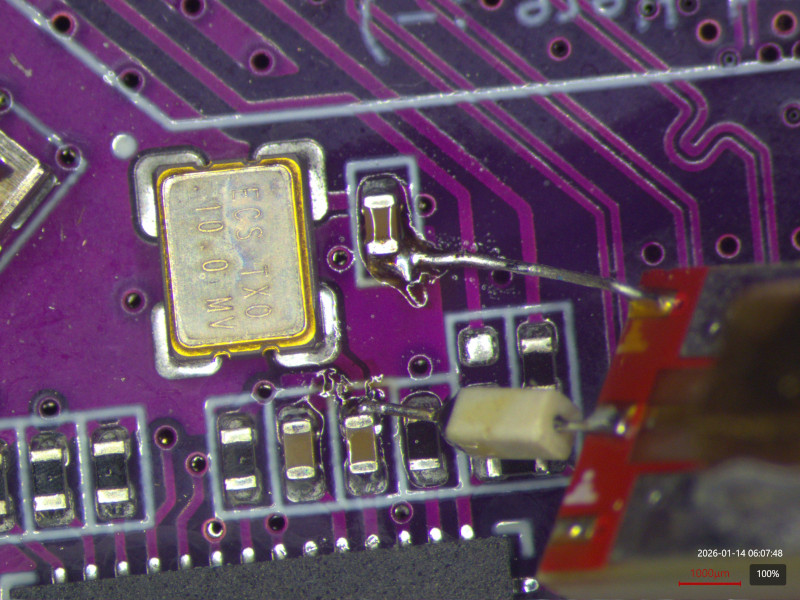

## ThunderScope 示波器时基故障与分析

一月份,作者收到了一款 PCIe 版本的 ThunderScope 开源硬件示波器,用于与他们的强大台式机进行测试。初步测试显示时基慢了 6.6%,追溯到一颗失效的 10 MHz TCXO(温补晶振)。由于 TCXO 输出信号平坦,锁相环 (PLL) 未能锁定。

更换 TCXO 后,示波器功能正常,促使作者对故障进行了更深入的调查。拆解和显微分析显示,连接 TCXO 晶体与控制器芯片的键合线断裂。这可能由于之前的超声波清洗而加剧,由于潜在的共振损坏,超声波清洗对振荡器来说是一个有风险的过程。

控制器 IC 本身似乎没有损坏,晶体测试结果也在规格范围内。故障似乎是潜在的弱键合以及超声波引起的应力共同作用的结果。另一位用户报告的第二次类似故障加强了这一结论。作者现在运营着一个“幕后半导体失效分析实验室”,详细介绍了拆解过程,重点介绍了 TCXO 的结构以及微观故障分析的挑战。

## ThunderScope 示波器时基故障与分析

一月份,作者收到了一款 PCIe 版本的 ThunderScope 开源硬件示波器,用于与他们的强大台式机进行测试。初步测试显示时基慢了 6.6%,追溯到一颗失效的 10 MHz TCXO(温补晶振)。由于 TCXO 输出信号平坦,锁相环 (PLL) 未能锁定。

更换 TCXO 后,示波器功能正常,促使作者对故障进行了更深入的调查。拆解和显微分析显示,连接 TCXO 晶体与控制器芯片的键合线断裂。这可能由于之前的超声波清洗而加剧,由于潜在的共振损坏,超声波清洗对振荡器来说是一个有风险的过程。

控制器 IC 本身似乎没有损坏,晶体测试结果也在规格范围内。故障似乎是潜在的弱键合以及超声波引起的应力共同作用的结果。另一位用户报告的第二次类似故障加强了这一结论。作者现在运营着一个“幕后半导体失效分析实验室”,详细介绍了拆解过程,重点介绍了 TCXO 的结构以及微观故障分析的挑战。