## 欧洲寻求数字独立 欧洲各国政府正在积极减少对微软和Zoom等美国大型科技公司的依赖,这源于对数据隐私、安全以及潜在政治影响力的担忧。在特朗普政府制裁影响国际组织以及担心数据访问被切断等事件发生后,这种“数字主权”的推动力日益增强。 法国正处于领先地位,计划到2027年禁止其250万公务员使用Zoom、Teams等美国视频会议工具,转而选择本土替代方案。德国和奥地利也在转向开源办公软件,部分地区甚至正在探索Linux操作系统。 这场运动源于对受外部控制的脆弱性的担忧——特别是来自美国和中国,以及对培养欧洲科技领导地位的渴望。尽管微软等美国公司强调在欧洲的数据保护,但官员们认为真正的独立需要本土或开源解决方案。这种转变正在获得进展,成为全球论坛上的一个关键讨论点,并促使了“主权云”等倡议的出现——这些数据中心由欧洲实体独立运营。

每日HackerNews RSS

This appears to be a corrupted PDF file containing binary data, not readable text. Therefore, a meaningful translation into Chinese is impossible. It's mostly gibberish. It's not possible to provide a Chinese translation of this content as it is not coherent text.

## 人工智能、版权与岌岌可危的体系 数十年以来,版权法一直基于一些不成文的假设:创作是缓慢的,分发是昂贵的,执法是自由裁量的。例如,粉丝艺术就存在于一个被容忍的灰色地带——个人使用可以,出售则不行。生成式人工智能打破了这种平衡,将模糊性转化为巨大的法律和经济问题。 核心问题不是*新的*版权侵权,而是*规模*。试图在“训练”阶段执行版权(阻止人工智能学习受版权保护的材料)是不切实际的——互联网充斥着合法使用的受版权保护的内容,并且将其解开是不可能的。监管“生成”同样存在缺陷,因为意图无法确定,处罚也变得荒谬地不成比例。 有效的执法最终取决于*分发*——实际发生损害的地方——这反映了现有的在线版权实践。然而,即使这样也存在过度监管和扼杀创造力的风险。此外,全球人工智能发展意味着美国的法规可能无效,可能会将创新推向其他地区。 归根结底,为内容稀缺的世界而建立的现有版权法,难以应对人工智能创造流畅、个性化体验的能力。这场辩论不仅仅是关于修复现有规则,而是认识到内容的本质正在发生变化,使传统的版权概念日益过时。我们试图监管一个正在消失的世界,而未来需要提出新的问题。

## Prek:`pre-commit` 的更快替代方案 Prek 是一个重新设计的、基于 Rust 的框架,旨在作为流行的 `pre-commit` 工具的直接替代品。它的目标是更快、更高效、无依赖——无需 Python 或其他运行时——同时添加长期以来要求的特性。Prek 已经被 CPython 和 FastAPI 等项目采用,它提供了显著的性能提升,使用的磁盘空间最多减少一半,运行速度比其前身快数倍。 主要特性包括内置的 monorepo 支持、与 `uv` 的集成以优化 Python 环境管理,以及改进的各种语言(Python、Node.js、Go 等)的工具链安装。Prek 还以 Rust 原生实现了一些常见的钩子以提高速度,并支持使用 `repo: builtin` 的离线钩子。 安装通过 shell 脚本、包管理器(pip、npm、Homebrew、Nix、Conda、Scoop)或预构建的二进制文件非常简单。Prek 提供了增强的命令行功能,例如在特定目录或上一次提交上运行钩子,以及改进的钩子列表和自动更新功能。 虽然仍处于发展阶段,但 Prek 正在迅速成熟,并为寻求简化和高性能 pre-commit 工作流程的开发人员提供了一个引人注目的替代方案。

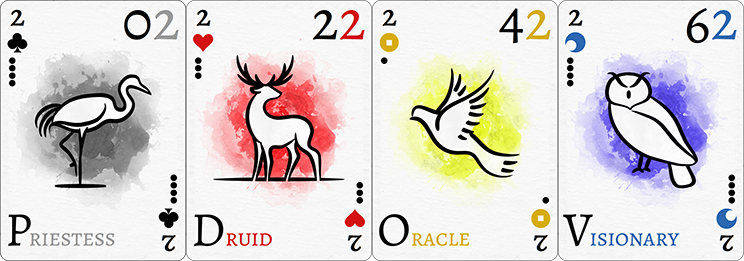

## 永恒牌:通用卡牌系统

永恒牌是一个独特设计的120张卡牌系统,旨在提供多功能性。它既可以作为便携式游戏伴侣,也可以作为现有游戏的替代品,还可以作为游戏设计师的工具——能够支持众多传统和现代卡牌游戏。

它的设计优先考虑组合效率,包含八种动物主题的花色(按颜色配对:黑色、红色、黄色、蓝色),牌面等级为0-9和人头牌(X、J、Q、K、A)。卡牌具有独特的名称和编号,包含点数值(1-5)和字母频率,模仿英语语言分布以用于文字游戏。

永恒牌可以轻松适应标准的52张卡牌游戏,充当双副牌,甚至可以映射到78张塔罗牌。它的编号系统允许进行像《无需感谢!》和《心有灵犀》这样的游戏,而花色区分(“柔”与“刚”)则提供进一步的游戏选项。

最终,永恒牌旨在兼具美观和实用性,为无数卡牌游戏体验提供灵活的基础。它目前可在DriveThruCards.com上购买,并在BoardGameGeek上设有专门页面。

## 永恒牌:通用卡牌系统

永恒牌是一个独特设计的120张卡牌系统,旨在提供多功能性。它既可以作为便携式游戏伴侣,也可以作为现有游戏的替代品,还可以作为游戏设计师的工具——能够支持众多传统和现代卡牌游戏。

它的设计优先考虑组合效率,包含八种动物主题的花色(按颜色配对:黑色、红色、黄色、蓝色),牌面等级为0-9和人头牌(X、J、Q、K、A)。卡牌具有独特的名称和编号,包含点数值(1-5)和字母频率,模仿英语语言分布以用于文字游戏。

永恒牌可以轻松适应标准的52张卡牌游戏,充当双副牌,甚至可以映射到78张塔罗牌。它的编号系统允许进行像《无需感谢!》和《心有灵犀》这样的游戏,而花色区分(“柔”与“刚”)则提供进一步的游戏选项。

最终,永恒牌旨在兼具美观和实用性,为无数卡牌游戏体验提供灵活的基础。它目前可在DriveThruCards.com上购买,并在BoardGameGeek上设有专门页面。

Please provide the content you want me to translate. I need the text to be able to translate it to Chinese.

启用 JavaScript 和 Cookie 以继续。

一份新报告揭示了一种影响美国公务人员的危险“数据到暴力”链条。虽然全国范围内的消费者隐私法正在增加,但它们未能充分保护这些个人免受其个人信息(如家庭住址)的泄露——这些信息易于通过公共记录获取,并由数据经纪人出售。 安全项目发布的报告发现,没有州法律允许公务人员从公共来源中删除他们的数据,也没有为隐私侵权提供法律补救途径。这使他们尤其容易受到威胁,特别是针对地方层面的公务人员(如校董事会成员、选举工作人员)的威胁正在增加。 最近的事件,例如对明尼苏达州众议员的刺杀未遂,表明了易于获取的数据如何助长有针对性的骚扰和暴力。该报告呼吁立法平衡第一修正案权利与对公务人员更强的隐私保护,重点是监管对数字化公共记录的*访问*,而不是完全限制这些记录。

## WhatsApp 面临安全与隐私问题 WhatsApp 被 Meta 收购后,用户对其信任度不断下降,尽管已采用端到端加密,但仍存在隐私方面的担忧。近期的问题加剧了这些顾虑。 Google 的 Project Zero 发现了一种漏洞,恶意文件只需通过将用户添加到 Android 上的 WhatsApp 群组即可下载——这是一种“零点击”攻击。虽然可能被用于定向活动,但它构成重大风险。 更严重的是,一项诉讼声称 Meta 即使在承诺加密的情况下也能访问用户通信,这源于 2023 年底的一次服务器更改。Meta 正在努力进行全面修复。 **为了降低风险,用户应:** * **禁用自动媒体下载:** 防止文件静默下载到您的设备。 * **限制群组访问:** 限制谁可以将您添加到群组。 * **启用双重验证:** 添加额外的账户安全层。 * **保持 WhatsApp 更新:** 确保您拥有最新的安全补丁。 这些步骤旨在控制 WhatsApp 内的潜在威胁,并防止恶意文件影响您的设备。