启用 JavaScript 和 Cookie 以继续。

每日HackerNews RSS

## 信任的两面与人工智能的未来 我们 постоянно 依赖信任,常常在不知不觉中——从手机闹钟叫醒我们,到复杂的系统使航空旅行成为可能。这种信任并非个人信任(“人际信任”),而是基于可靠性和可预测性(“社会信任”),由法律和技术等系统强制执行。两者都至关重要,但社会信任能够扩展到复杂的社会,从而实现陌生人之间的合作。 演讲者认为,随着人工智能的兴起,我们将混淆这两种类型的信任。企业将利用这一点,将人工智能呈现为“朋友”,而它们仅仅是受利润驱动,而非道德驱动的服务。真正的可信赖性需要透明度和问责制,而市场无法提供这些。 因此,政府监管至关重要——不是监管人工智能本身,而是监管*控制*人工智能的组织。这包括建立人工智能透明法、安全法规,以及采用“数据受托人”模式,让公司对保护用户数据负责。至关重要的是,需要公共拥有的AI模型来平衡企业控制,并确保人工智能服务于公众利益。 最终,政府的作用是建立和维护社会信任,确保人工智能成为可靠的服务,而不是被剥削的工具。

彭博社 需要帮助?请联系我们 我们检测到您的计算机网络存在异常活动 要继续,请点击下面的框来确认您不是机器人。 为什么会发生这种情况? 请确保您的浏览器支持 JavaScript 和 cookies,并且没有阻止它们加载。 更多信息请查看我们的服务条款 和 Cookie 政策。 需要帮助? 关于此消息的咨询,请联系 我们的支持团队并提供以下参考ID。 阻止参考ID:fb99f468-0143-11f1-bed6-6418229cafc3 通过彭博社订阅,随时掌握最重要的全球市场新闻。 立即订阅

## Oxen 通过代码精简实现性能提升 20 倍

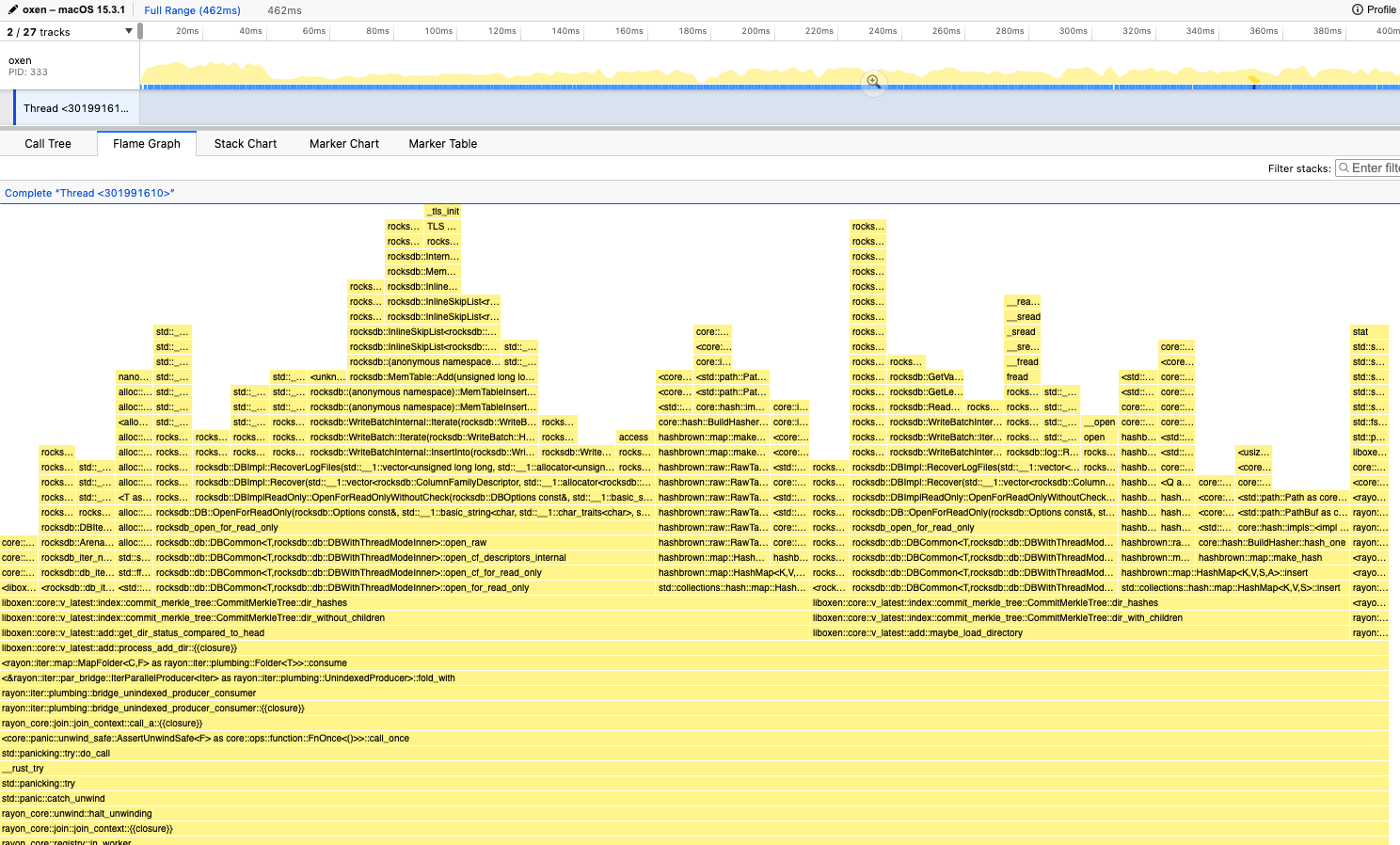

Oxen 是一款数据版本控制工具,致力于追求卓越性能,并定期使用多太字节数据集对命令进行基准测试。虽然 `add` 命令速度很快,但 `commit` 命令即使是一个理论上简单的操作,也需要超过 50 分钟。

性能分析显示,`commit` 命令的 90% 时间都花在了获取暂存 RocksDB 的锁上。根本原因是什么?由于不同代码层之间存在过多的数据克隆和重复的数据库打开,导致线程竞争。尽管职责分离定义明确,但每一层都重复获取相同的文件信息。

一个 PR 消除了这种冗余的数据访问,从而实现了 **20 倍的速度提升**。这凸显了一个关键教训:看似孤立的功能会对整个系统产生影响。此外,团队注意到 RocksDB 针对写入进行了优化,并不适合他们并行且读取密集型的提交过程。这段经历强化了“少即是多”的原则,尤其是在对性能敏感的应用中。

## Oxen 通过代码精简实现性能提升 20 倍

Oxen 是一款数据版本控制工具,致力于追求卓越性能,并定期使用多太字节数据集对命令进行基准测试。虽然 `add` 命令速度很快,但 `commit` 命令即使是一个理论上简单的操作,也需要超过 50 分钟。

性能分析显示,`commit` 命令的 90% 时间都花在了获取暂存 RocksDB 的锁上。根本原因是什么?由于不同代码层之间存在过多的数据克隆和重复的数据库打开,导致线程竞争。尽管职责分离定义明确,但每一层都重复获取相同的文件信息。

一个 PR 消除了这种冗余的数据访问,从而实现了 **20 倍的速度提升**。这凸显了一个关键教训:看似孤立的功能会对整个系统产生影响。此外,团队注意到 RocksDB 针对写入进行了优化,并不适合他们并行且读取密集型的提交过程。这段经历强化了“少即是多”的原则,尤其是在对性能敏感的应用中。

一项最新研究表明,使用像GitHub Copilot这样的LLM聊天机器人*生成*代码的“氛围编程”对开源生态系统构成重大威胁。核心问题在于开发者与开源项目的直接互动减少。开发者不再理解和参与库的使用,而是依赖于聊天机器人的输出,可能偏向于LLM训练数据中流行的代码,而非*最佳*代码。

这会减少项目网站的流量,阻碍资金和社区发展,类似于对Spotify等平台上艺术家报酬的担忧。此外,LLM不会回馈它们所使用的项目——没有错误报告,没有社区参与。

早期数据表明,“氛围编程”并没有显著提高生产力,甚至可能*增加*错误并降低开发人员的技能。虽然人工智能技术本身并非负面,但该研究警告说,将开发委托给LLM最终可能会扼杀创新,并损害对开源至关重要的协作精神,尤其是在JavaScript和Python等生态系统中。

一项最新研究表明,使用像GitHub Copilot这样的LLM聊天机器人*生成*代码的“氛围编程”对开源生态系统构成重大威胁。核心问题在于开发者与开源项目的直接互动减少。开发者不再理解和参与库的使用,而是依赖于聊天机器人的输出,可能偏向于LLM训练数据中流行的代码,而非*最佳*代码。

这会减少项目网站的流量,阻碍资金和社区发展,类似于对Spotify等平台上艺术家报酬的担忧。此外,LLM不会回馈它们所使用的项目——没有错误报告,没有社区参与。

早期数据表明,“氛围编程”并没有显著提高生产力,甚至可能*增加*错误并降低开发人员的技能。虽然人工智能技术本身并非负面,但该研究警告说,将开发委托给LLM最终可能会扼杀创新,并损害对开源至关重要的协作精神,尤其是在JavaScript和Python等生态系统中。

这篇内容探讨了伦敦多层次的历史,以及在现代城市之下寻找隐藏之城的探索。从布鲁图斯建立伦敦的神话开始,叙述追溯了一系列在城市肌理中寻求替代现实的 visionaries(有远见者)、outcasts(弃儿)和 revolutionaries(革命者)。

作者深入研究了情境主义国际的理念,他们将城市环境视为控制的工具——“景观”,并试图通过“心理地理学”来扰乱它,即探索城市的情感和行为影响。这种追求与伦敦的神秘历史交织在一起,提到了约翰·迪和艾伦·摩尔等人物,以及城市持久的神秘暗流。

作者从 80 年代的经历到最近的回归,在伦敦的个人旅程变成了一场寻找这个“另一个伦敦”的旅程——一个充满隐藏意义和未实现可能性的地方。与一位用多肉植物收复空间的园丁的相遇象征着重新施魔法的潜力。最终,这篇文章表明,尽管监控日益增加和“现实”占据主导地位,但发现充满活力、替代的伦敦的可能性仍然存在,这需要人们愿意超越表面现象。

这篇内容探讨了伦敦多层次的历史,以及在现代城市之下寻找隐藏之城的探索。从布鲁图斯建立伦敦的神话开始,叙述追溯了一系列在城市肌理中寻求替代现实的 visionaries(有远见者)、outcasts(弃儿)和 revolutionaries(革命者)。

作者深入研究了情境主义国际的理念,他们将城市环境视为控制的工具——“景观”,并试图通过“心理地理学”来扰乱它,即探索城市的情感和行为影响。这种追求与伦敦的神秘历史交织在一起,提到了约翰·迪和艾伦·摩尔等人物,以及城市持久的神秘暗流。

作者从 80 年代的经历到最近的回归,在伦敦的个人旅程变成了一场寻找这个“另一个伦敦”的旅程——一个充满隐藏意义和未实现可能性的地方。与一位用多肉植物收复空间的园丁的相遇象征着重新施魔法的潜力。最终,这篇文章表明,尽管监控日益增加和“现实”占据主导地位,但发现充满活力、替代的伦敦的可能性仍然存在,这需要人们愿意超越表面现象。

## 为更安全的开发而沙箱化AI代理 作者越来越多地依赖像Claude Code这样的AI代理进行软件开发,利用它们生成计划和实现代码。然而,持续的文件访问和软件执行权限请求会打断工作流程。虽然存在“YOLO”模式,但它存在安全风险。 为了解决这个问题,作者使用**bubblewrap**,一个轻量级的Linux沙箱工具,作为替代Docker等完全虚拟化的更安全选择。目标是创建一个隔离的环境,模拟他们的常规开发设置,并限制访问权限——仅限于项目文件和必要的网络连接。 作者分享了一个定制的bubblewrap脚本来实现这一点,重点是绑定挂载必要的目录,同时限制更广泛的系统访问。这种方法优先考虑便利性,并最大程度地减少配置开销。虽然这不是一个万无一失的安全解决方案,但作者认为鉴于他们的风险承受能力和现有的版本控制实践(Git),这已经足够了。 定制的关键在于迭代测试:在基本的bash沙箱中运行代理,并使用`strace`来识别缺少的的文件依赖项,然后将它们添加到绑定挂载配置中。这允许创建一个定制的、最小化的沙箱设置。

## PII-Shield:Kubernetes零代码日志脱敏

PII-Shield是一个高性能、零代码的Kubernetes边车容器,旨在通过在日志离开应用程序*之前*屏蔽个人身份信息 (PII) 来防止数据泄露。与传统的日志过滤方法(如Fluentd/Logstash中的正则表达式)相比,PII-Shield使用Go语言编写,具有低延迟处理能力,速度更快且资源消耗更少。

它利用上下文感知的熵分析来检测密钥——即使没有已知密钥——并将其替换为确定性哈希(例如,`[HIDDEN:a1b2c]`),以便在不暴露敏感数据的情况下进行质量保证关联。

PII-Shield无需代码更改,适用于任何语言,并且可以作为边车轻松部署,使用initContainer复制二进制文件即可。它经过严格测试,在各种场景下均具有高精度,包括多语言日志和复杂数据结构。配置通过环境变量管理,包括生产环境所需的HMAC盐。

在Docker Hub上找到它:`docker pull thelisdeep/pii-shield:latest`。